今天突然想写一些比较虚的东西。想结合普通人的决策因素来讲讲我对人工智能的理解。

人来“决策”

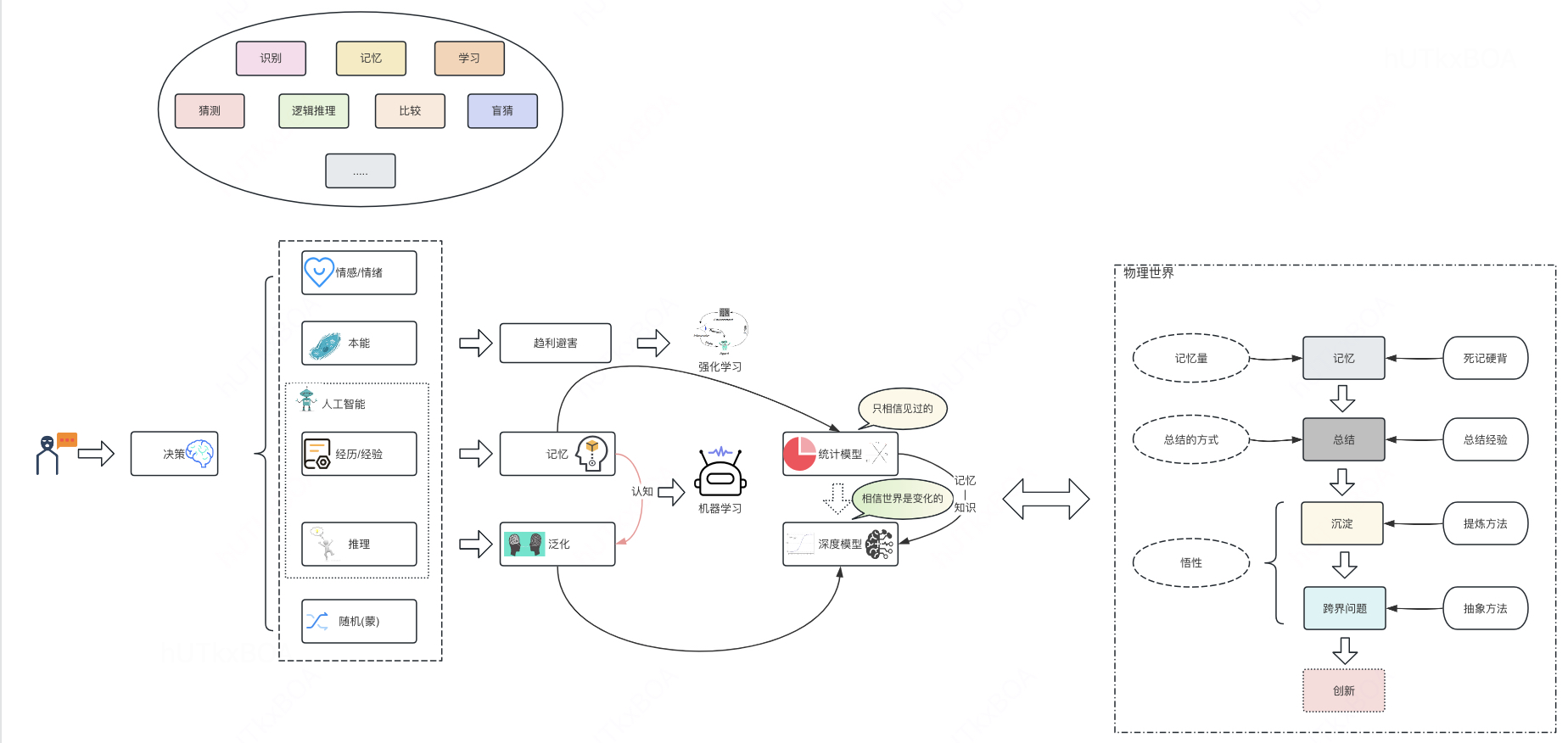

每个人在生活中要面临各种各样的决策/判定,那么一个问题是我比较好奇的, 我们平时决策的时候究竟有哪些因素影响我们,能让我们在漫漫人生长河中能做出来相对正确的决策的原因是什么呢? 如果能搞清楚,是不是就能感性的视角推导出模型学习的过程到底在做什么呢?这个就是今天咱们要聊的核心话题。

我们经常用模型去做业务场景的分类或者是物体的识别,这个时候如果让你来给出一个事情的分类/判断,你需要考虑到哪些因素呢?

- 第一个我觉的应该是情感驱动的,如果让你表达关于你亲人的判断,相信你会避重就轻的表达观点,是的,情感是影响你决策的一个关键因素。

- 抛出情感以外呢,就是人类的本能反应了, 如果有人打你,你的第一决策是什么呢,一定是躲避或者逃跑,这也是一个你决策的标准。

- 在往下就是经历和经验了。如果让你钓鱼,你是选择相对平静的水域还是水流湍急的水域呢? 驱使你做这样的决策就是经历或者经验,当然这个经历或者经验并不都是你自己尝试出来的,也可以是看别人的经历或者老人教你的经验。 但是都是你决策的一部分。

- 推理也是你决策的重要因素,让你发传单,在指定的时间内发完,虽然你没有干过这个活,但是你通过思考和推理应该能知道,我们应该去人密集的地方去发,而不是在很偏僻的地方发,当然这个也可以按照“聪明”理解,所谓的聪明就是面对未知的思维能够快速找到解决问题的办法(邻居家的小孩)

- 最后一种就是随机了,人生中总有那么几件事情,你没有任何参考,连推理的信息都没有,就只能靠蒙。

那么人工智能究竟要做什么事情呢?接下来让我们看看模型决策和人决策的异同点。

模型“决策”

我们知道所谓的模型决策其实就是使用海量数据进行学习,然后使用在某些场景的工具,例如图像识别是通过模型进行图像的分类。那么问题来了,我们超级想通过人工智能训练一个人,这个人是否像咱们上面介绍的一样,拥有很多维度的思考呢? 在情感维度,可能大家决策模型决策一定不会有这方面的倾斜,其实情感是通过训练数据传递给模型的,假如标注人员对一个事情特别有情怀,那么他们标注的数据就传递给了了模型,当然我们希望模型能够是大公无私的,仅仅做最公正的决策。

对于趋利避害的能力,其实是通过强化的学习的方式进行学习的,想想强化学习的过程, 你做了不好的决定就给你一个很大的惩罚,做的好了就给以很好的奖励,通过这样的方式学习了就让模型依靠本能学习了一项技能。这与深度学习的方式也有异曲同工之妙, 深度学习是通过损失函数的形式告诉模型学习的知识的对错,看起来这些模型都是通过某种形式塑造认知(损失函数/奖励函数),最终让模型学习某一类事物从而具备对这类事物的判断能力。

当然你会发现不同的模型使用同样的数据学习的结果大有不同, 学过模型的同学会下意识的说这是因为不同的模型拟合能力是不同的,这是对的,其实我更想把他理解成这是不同的人对不同的事物理解程度不同,因为聪明程度,因为变通程度的不同导致的。

对于模型来讲,其实最重要的就是学习记忆能力和推理能力,这也是作为人类的高阶能力,想想一个人的成长历程, 从小学习知识因为不懂其中的原理,免不了死记硬背,当画好出题范围的时候,你也能够考取很好的成绩,但是面对实际问题的时候却束手无策, 这就是记忆能力,从模型的视角讲, 不同的人记忆力是不同的,可以理解成记忆容量的不同,对于模型也是一样的, 一些小参数的模型,能够记忆能力是被压缩的,例如我们使用LR模型的时候,所有的数据表现都变成最后的特征权重,其实就是经过海量数据压缩以后的结果。而当我们把一个深度模型做的特别宽的时候,其实也是在让记忆的内容尽可能的细致,而不是仅仅记录一个轮廓。

另一个于此类似的能力就是推理能力,这个可以映射到我们学习数学的过程,学习的数学的时候,开局一些晦涩的定理, 用这些晦涩的定理要进行解题就需要强大的推理能力, 所以一般数学题不会通过背诵的方式学习也是这个原因。那么对于模型来讲, 通过增加模型深度,增加非线性单元,增加泛化能力,其实某种意义上就是为了增加模型的推理能力,这在我们模型设计的时候也可以通过这些方面考虑模型结构应该如何设计。

像是残差网络结果,就是为了解决当你推理链路过长的时候,经常忘记了最开始给你的已知条件,导致你的推导进入一个死循环。

模型的“理解”

这里可以进一步延伸一个话题,不同类型的模型理解世界的方式是不一样的,例如统计类模型,这类模型理解世界的方式是以概率的视角理解,大部分情况下发生的情况,就是影响模型决策的最大考量点,本来这是无可厚非的, 只不是世界比较险恶, 仅仅通过概率的方式决策往往会要接受世界不存在100%的事情, 所以这类决策往往就是不求甚解的结果,当然这里有一个小小trick, 如果你能把影响这个世界的全集都给你,那么你就能做出很优质的决策, 这就是为啥有人说当你把xgboost的特征做到极致,比深度学习也不虚。

于此相同就是深度学习,你给我的输入,我要经过层层变换思考,再加上第六感(非线性变换)的加持,最终给出一个判定结果,因为思考深度提升了,自然结果会会更好的。当然,当你没有足够的数据量,再多的变换思考都是“自嗨”, 这也好理解深度学习为啥需要那么多数据。

物理世界

最后咱们从物理世界的视角去看一个人的成长历程,一板一眼的成长永远都是通过最擅长的记忆方式理解这个这个世界,当记忆的足够多了,就发现,这么记下去有点太累了,然后开始总结,总结最开始只是记忆碎片的合并,减少记忆量的方式,最终还会进化到下一个阶段沉淀,所谓沉淀是把一些记忆的内容变成认知,变成肌肉记忆, 这样当遇到一些问题的时候,我们会通过一套规则判断,这套规则不仅仅是记忆的压缩,而是一套标准, 这样就能解决更加广泛的问题。

真正的下半场就是跨界的问题了, 你究竟是沉淀出了认知,还是沉淀出摸索世界的方式,就是这一部分的关键了。感觉上这个是AI的极限。

最后的最后就是创新了,这也是AI不容易学习得到的部分,在新的事物下,是否能有让人有眼前一亮的感受,依赖的是最底层的创新能力。AI能够做好的更多是多个领域迁移的创意,但是真正的创新可能是少之又少。

总而言之

闲来无事写了这么一大堆东西,其实不是纯粹的想讲机器学习深度学习之类的东西,只是理解了不同的学习方式造就的是不同的理解世界的方式, 有的笨一点就要多学点,有的聪明一点就是少走一点弯路,可能对于算法工程师而言更多的不要抱怨机器学习为啥没学好,只是基于模型自己的认知做出的一种判断,现实中改变一个人都十分难,更何况你要改变模型认知。